YouTube removeu mais de oito milhões de vídeos entre outubro e dezembro de 2017

Entre os meses de outubro e dezembro de 2017, mais de 8,2 milhões de vídeos foram removidos do YouTube - a maioria deles identificados por sistemas automatizados por irem contra os termos de uso da plataforma ou apresentarem conteúdo irregular ou violento. Os dados aparecem na primeira edição de um relatório trimestral de transparência, que será divulgado a partir de agora pela Google como parte de seus esforços para tornar a plataforma de vídeos um ambiente mais saudável e seguro.

Os números apontam que, dos mais de oito milhões de vídeos removidos durante os três últimos meses do ano passado, a esmagadora maioria foi constituída de spams ou uploads de conteúdos adultos. Desse total, 6,7 milhões foram detectados por sistemas automatizados, com 76% sendo removidos por estas mesmas tecnologias antes que recebessem uma única visualização sequer.

Indicações feitas por revisores humanos representaram 1,1 milhão de vídeos removidos, enquanto as indicações feitas por usuários, através de sistemas de denúncias, constituíram 402 mil conteúdos. Por fim, 63,9 mil deles foram indicados ao YouTube por meio de parcerias com organizações de direitos civis voltadas, também, para tornar o ambiente mais saudável, enquanto apenas 73 vídeos tiveram sua retirada solicitada por governos ou agentes ligados a eles.

Quando um vídeo não foi removido imediatamente após o upload, o alcance também foi pequeno. Nesse caso, a Google não falou em números, dizendo apenas que os views recebidos por tais conteúdos representaram apenas "uma fração" de 1% das visualizações totais registradas na plataforma durante o período. É um número, também, que vem decrescendo, muito pela força dos sistemas automatizados que hoje são a principal linha de defesa do YouTube na aplicação de suas regras.

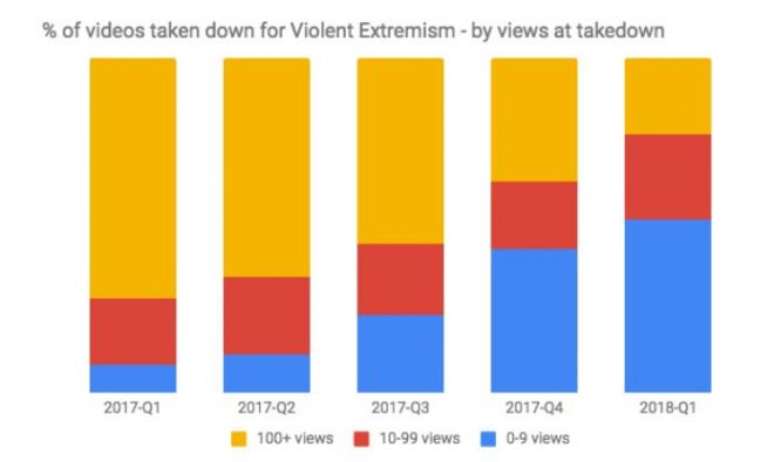

Para demonstrar isso, a Google utilizou um gráfico temporal relacionado a vídeos extremistas e com conteúdo violento. As ferramentas de identificação de conteúdos irregulares ganharam incremento no final do segundo trimestre de 2017 e, na mesma época, também cresceu exponencialmente o total de remoções antes mesmo que os conteúdos ultrapassassem a marca das 10 visualizações, com mais de metade deles sendo removidos praticamente de forma imediata após a postagem.

Ao falar sobre a tecnologia, a Google afirma que o uso de sistemas automatizados funciona como se "mais pessoas estivesse revisando conteúdo, não menos". Isso se deve ao fato de seus "robôs" levarem em conta a análise manual como forma de entender quais conteúdos podem passar e quais devem ser retidos, uma maneira de, ao mesmo tempo, lidar com o gigantesco fluxo de vídeos sendo hospedados na plataforma e permitir que aqueles que cumprem as regras não sejam atingidos erroneamente por elas.

Com a divulgação do relatório de transparência, a Google reforçou seu compromisso de ter mais de 10 mil pessoas trabalhando exclusivamente em revisão de conteúdo até o final de 2018. Isso está envolvendo, por exemplo, não apenas a contratação de gente para efetivamente assistir e avaliar conteúdos hospedados, mas também o contato com especialistas em terrorismo, direitos humanos, extremismo e outros assuntos de interesse em diversas regiões do mundo, bem como a parceria com associações de direitos civis e universidades.